Wikipédia:Sélection/Technologies

Risque de catastrophe planétaire La notion de risque de catastrophe planétaire ou de catastrophe globale a été introduite en 2008 par le philosophe Nick Bostrom pour désigner un évènement futur hypothétique qui aurait le potentiel de dégrader le bien-être de la majeure partie de l’humanité, par exemple en détruisant la civilisation moderne ; il avait proposé également dès 2002 d'appeler risque existentiel un évènement qui pourrait causer l’extinction de l'humanité. Parmi les catastrophes planétaires potentielles figurent les changements climatiques, les pandémies et les guerres nucléaires, mais également des risques liés aux nanotechnologies ou à une prise de contrôle par une intelligence artificielle hostile, ainsi que des catastrophes cosmiques telles que des impacts de météorites. Une étude quantitative rigoureuse de ces risques est difficile, en raison de l’incertitude sur les conséquences finales (les enjeux) de l’aléa déclencheur de la catastrophe, et sur la probabilité de cet aléa, et aussi parce que de nombreux biais cognitifs en compliquent l’analyse ; de plus, un évènement ayant pu provoquer l’extinction de l’humanité ou la destruction complète de la civilisation ne s’étant évidemment encore jamais produit, la probabilité qu’il en advienne un est minimisée ; ce phénomène est connu en statistique sous le nom de biais de sélection. Bien que les risques de catastrophe planétaire aient fait l’objet de nombreux scénarios de science-fiction (modernisant souvent des mythes très anciens comme celui de Pandore), et de déclarations alarmistes à partir des années 1950, ce n'est qu’au début du XXIe siècle que divers organismes ont commencé à les étudier systématiquement, en particulier sous l’impulsion des mouvements transhumanistes. |

Technologie sous la dynastie Song La dynastie Song (chinois : 宋朝 ; 960–1279) apporte les avancées techniques les plus significatives de l'histoire de la Chine, dont la plupart émanent des talentueux fonctionnaires recrutés par les examens impériaux. L'ingéniosité des avancées en génie mécanique est une longue tradition en Chine. L'ingénieur de la dynastie Song Su Song admet que lui et ses contemporains se sont appuyés sur les travaux d'anciens tels que Zhang Heng (78-139), un astronome, inventeur et maître en matière d'engrenages. L'utilisation des caractères d'imprimerie mobiles accélère l'usage déjà répandu de blocs en bois afin de pouvoir éduquer les étudiants confucianistes et le peuple. L'apparition de nouvelles armes utilisant de la poudre à canon permet aux Song de survivre face à leurs ennemis, les dynasties Liao, des Xia occidentaux et des Jin, jusqu'à l'effondrement de la dynastie sous les coups des Mongols de Kublai Khan à la fin du XIIIe siècle. Des avancées notables en génie civil, génie maritime et métallurgie sont faites en Chine durant la période Song, comme l'introduction de moulins à vent en Chine durant le XIIIe siècle. Ces avancées, avec l'apparition du billet de banque, aident la révolution et le maintien de l'économie de la dynastie Song. |

Bentley 4½ Litre La Bentley 4½ Litre ou Bentley 4,5 Litre est une automobile sportive de luxe de la seconde moitié des années 1920, développée par le constructeur automobile britannique Bentley. Remplaçante de la Bentley 3 Litre, elle est particulièrement réputée au Royaume-Uni en tant que modèle emblématique des automobiles de course britanniques d’avant-guerre, et populaire pour cette phrase prononcée lors de sa conception par le fondateur de Bentley, Walter Owen Bentley : « There’s no replacement for displacement ». Par cette expression idiomatique, W.O. Bentley marque sa volonté de produire une automobile de course bien plus puissante via une augmentation importante de sa cylindrée. À l’époque de la 4½ Litre, les grands constructeurs automobiles tels que Bugatti ou Lorraine-Dietrich s’affrontent aux 24 Heures du Mans, une course d’endurance créée quelques années plus tôt, où sont alignées des sportives toujours plus performantes et plus rapides ; une victoire en compétition permet en effet de rapidement se construire une réputation. La 4½ Litre est produite à 720 exemplaires entre 1927 et 1931, dont 55 modèles disposant d’un moteur suralimenté – une version popularisée sous le nom de Bentley Blower. Certains de ces exemplaires remportent quelques épreuves, dont les 24 Heures du Mans. Si son palmarès sportif n’est pas particulièrement exceptionnel, la Bentley 4½ Litre bat néanmoins de nombreux records de vitesse absolue, dont le plus célèbre est remporté en 1932 sur le circuit de Brooklands avec une vitesse de 222,03 km/h. |

Bentley 6½ Litre La Bentley 6½ Litre ou Bentley 6,5 Litre est une automobile sportive de luxe de la seconde moitié des années 1920, développée par le constructeur automobile britannique Bentley. Destinée à concourir en compétition, elle doit d’une certaine manière assurer la relève de la Bentley 3 Litre, la première automobile du constructeur, dont le palmarès sportif compte, en 1926, une victoire aux 24 Heures du Mans. Créée en 1923 et se déroulant sur le circuit de la Sarthe, cette course d’endurance de 24 heures séduit rapidement de nombreux pilotes et écuries, dont Bentley, qui y engage officiellement plusieurs automobiles dès 1925. Cependant, la concurrence se fait de plus en plus vive, les performances et les vitesses de pointe des automobiles de course ne cessant d’augmenter. Pour préserver sa compétitivité, Bentley développe son premier moteur 6 cylindres en ligne d’une cylindrée de 6,6 litres, capable de délivrer une puissance de 147 ch. Pour autant, la 6½ Litre ne connaîtra que des déboires, mettant Bentley dans une situation difficile. En 1928, Bentley entame la production d’une déclinaison plus performante de la 6½ Litre, grâce notamment à l’ajout d’un second carburateur. Connue sous le nom de Bentley Speed Six, cette version améliorée redore le blason de la 6½ Litre, en signant deux victoires consécutives aux 24 Heures du Mans 1929 et 1930 – succédant ainsi dignement à la 3 Litre et à la 4½ Litre, qui ont respectivement remporté les trophées de 1927 et de 1928 –, faisant d’elle l’une des plus fameuses automobiles du début du XXe siècle et de Bentley, l’un des constructeurs automobiles les plus célèbres. |

Bugatti Type 35 La Bugatti Type 35 « Grand Prix » est une automobile sportive de la seconde moitié des années 1920 développée par le constructeur automobile français Bugatti. Forte d'un palmarès toujours inégalé, avec plus de deux mille victoires en compétition dont cinq succès consécutifs à la Targa Florio, elle est non seulement la Bugatti la plus célèbre mais compte également parmi les voitures ayant le plus marqué l’histoire de l’automobile. La naissance du mythe des « Pur-sang » Bugatti date d’ailleurs de cette époque. Conçue à partir de 1924 dans les ateliers Bugatti de Molsheim-Dorlisheim en Alsace, la Type 35 connaît de nombreuses évolutions mécaniques, portant essentiellement sur son moteur à huit cylindres en ligne, donnant naissance à différentes versions : Type 35, 35A, 35C, 35T, 35B, 37, 37A, 39 et 39A. Généralement considérée comme particulièrement élégante, la Type 35 est également à l’origine d’innovations techniques majeures dans l’automobile. Près de 640 exemplaires seront construits jusqu’en 1930. Si elle n’est pas particulièrement puissante, ses différents moteurs développant entre 60 et 140 chevaux, la Type 35 réussit toutefois à imposer son rythme en Grand Prix pendant près d’une décennie, grâce notamment à son comportement routier sain et sa fiabilité. Au début des années 1930, elle cède néanmoins sa place aux sportives des constructeurs italien Alfa Romeo et allemand Mercedes-Benz, qui bénéficient entre autres du soutien de la part des gouvernements de leurs pays respectifs. |

Ferrari 250 GT Cabriolet Pinin Farina La Ferrari 250 GT Cabriolet Pinin Farina, occasionnellement dénommée 250 GTC, est une sportive de prestige développée par le constructeur automobile italien Ferrari. Déclinaison « cabriolet » de la berlinette 250 GT, elle est dessinée par le Turinois Pinin Farina ; elle est de surcroît carrossée par ses soins, une exception pour Ferrari puisque c'est un autre carrossier, Scaglietti, qui s'en charge habituellement. Produite de juillet 1957 à la fin de l'année 1962, la 250 GT Cabriolet est le premier cabriolet construit en série par Ferrari. Seul un petit volume d'une trentaine de modèles est dans un premier temps assemblé. Repérées par la désignation « première série » (en italien, prima serie), ces Ferrari cèdent leur place en à une deuxième version au dessin corrigé (« deuxième série », en italien seconda serie) qui s'écoulera à environ 200 exemplaires alors qu'il s'agit, à l'époque, de la plus chère des Ferrari 250 GT. |

Haut fourneau Un haut fourneau est une installation industrielle destinée à simultanément désoxyder et fondre les métaux contenus dans un minerai, par la combustion d'un combustible solide riche en carbone. En général, le haut fourneau transforme du minerai de fer en fonte liquide, en brûlant du coke qui sert à la fois de combustible et d'agent réducteur. Bien que la fonte produite soit un matériau à part entière, cet alliage est généralement destiné à être affiné dans des aciéries. Le haut fourneau produit de la fonte en fusion, par opposition au bas fourneau, qui produit une loupe de fer solide. Il en est pourtant une évolution directe, mais il ne s'est généralisé que lorsqu'on a su valoriser la fonte produite. Ainsi, la Chine développe dès le Ier siècle l'usage du haut fourneau en même temps que la fonderie. L'Occident ne l'adopte qu'après le XIIe siècle, avec la mise au point des méthodes d'affinage de la fonte en acier naturel. C'est là qu'il évolue vers sa forme actuelle, la généralisation du coke et du préchauffage de l'air de combustion contribuant à la première révolution industrielle. Devenu un outil géant, sans que son principe fondamental ne change, le haut fourneau est maintenant un ensemble d'installations associées à un four. Malgré l'ancienneté du principe, l'ensemble reste un outil extrêmement complexe et difficile à maîtriser. Son rendement thermique et chimique exceptionnel lui a permis de survivre, jusqu'au début du XXIe siècle, aux bouleversements techniques qui ont jalonné l'histoire de la production de l'acier. Qu'il soit « cathédrale de feu » ou « estomac », le haut fourneau est aussi un symbole qui résume souvent un complexe sidérurgique. Il n'en est pourtant qu'un maillon : situé au cœur du processus de fabrication de l'acier, il doit être associé à une cokerie, une usine d'agglomération et une aciérie, usines au moins aussi complexes et coûteuses. Mais la disparition de ces usines, régulièrement annoncée au vu des progrès de l'aciérie électrique et de la réduction directe, n'est pourtant toujours pas envisagée. |

Puddlage Le puddlage est un ancien procédé d'affinage de la fonte consistant à la décarburer dans un four à l'aide de scories oxydantes pour obtenir du fer puddlé à partir de fonte. Le mot puddlage vient du verbe anglais to puddle qui signifie « brasser ». La méthode est mise au point par Henry Cort en 1784, puis significativement améliorée par Samuel Baldwin Rogers et Joseph Hall au XIXe siècle. La fonte est chauffée à très haute température dans un four à réverbère. Le puddleur, l'ouvrier chargé de l'opération, active la réaction en brassant cette fonte à l'aide d'un long crochet appelé « ringard ». Une fois suffisamment affinée, la loupe est extraite du four, pour être cinglée par martelage ou laminage, puis est forgée en barres. Le puddlage permet la fabrication en grande quantité de fer, aux caractéristiques supérieures à celles de la fonte. Les arches de la gare de l'Est et la tour Eiffel à Paris sont ainsi réalisées en fer puddlé produit par la Société des Aciéries de Pompey. Après avoir été largement employé tout au long du XIXe siècle, le fer puddlé s'efface progressivement devant l'acier, plus compétitif et plus performant dès que les convertisseurs sont mis au point. |

Léonard de Vinci Léonard de Vinci (Leonardo di ser Piero da Vinci Après son enfance à Vinci, Léonard est élève auprès du célèbre peintre et sculpteur florentin Andrea del Verrocchio. Ses premiers travaux importants sont réalisés au service du duc Ludovic Sforza à Milan. Il œuvre ensuite à Rome, Bologne et Venise et passe les dernières années de sa vie en France, à l'invitation du roi François Ier. Léonard de Vinci est souvent décrit comme l'archétype et le symbole de l'homme de la Renaissance, un génie universel et un philosophe humaniste dont la curiosité infinie est seulement égalée par la force d'invention. Il est considéré comme un des plus grands peintres de tous les temps et peut-être la personne la plus talentueuse dans le plus grand nombre de domaines différents ayant jamais vécu. C'est d'abord comme peintre que Léonard de Vinci est reconnu. Deux de ses œuvres, La Joconde et La Cène, sont des peintures très célèbres, souvent copiées et parodiées, et son dessin de l’Homme de Vitruve est également repris dans de nombreux travaux dérivés. Seules une quinzaine d'œuvres sont parvenues jusqu'à nous ; ce petit nombre est dû à ses expérimentations constantes et parfois désastreuses de nouvelles techniques et à sa procrastination chronique. Néanmoins, ces quelques œuvres, jointes à ses carnets, qui contiennent des dessins, des diagrammes scientifiques et des réflexions sur la nature de la peinture, sont un legs aux générations suivantes d'artistes seulement égalé par Michel-Ange. Comme ingénieur et inventeur, Léonard développe des idées très en avance sur son temps, comme l'avion, l'hélicoptère, le char de combat, le sous-marin jusqu'à l'automobile. Très peu de ses projets sont construits, ou même seulement réalisables de son vivant, mais certaines de ses plus petites inventions comme une machine pour mesurer la limite élastique d'un câble entrent dans le monde de la manufacture. En tant que scientifique, Léonard de Vinci a beaucoup fait progresser la connaissance dans les domaines de l'anatomie, du génie civil, de l'optique et de l'hydrodynamique. |

Gaz naturel liquéfié Le gaz naturel liquéfié (abrégé en GNL, ou LNG de l'anglais liquefied natural gas) est du gaz naturel de qualité commerciale condensé à l’état liquide. Il se compose essentiellement de méthane mais comprend aussi jusqu'à 10 % d'éthane et de petites quantités d'autres gaz (propane et butane notamment). Le méthane devient liquide à une température de −161 °C à pression atmosphérique, il prend la forme d'un liquide clair, transparent, inodore, non corrosif et non toxique. Sous cette forme, le gaz a une masse volumique de 422,62 kg·m−3, occupant 600 fois moins de son volume que sous sa forme usuelle dans les CNTP, 60 % de moins que compressé à 200 bars. En tant que carburant, son PCI est de 22,4 MJ/l, soit 60 % de celui du gazole. Industriellement, le GNL est produit en grande quantité dans des usines cryogéniques. Il est principalement utilisé comme moyen de transporter le gaz naturel de pays producteurs vers des pays consommateurs par voie maritime. Environ 12 % du gaz naturel produit dans le monde en 2019 est acheminé selon cette méthode. Il peut aussi être vendu comme énergie finale, c'est-à-dire directement à des utilisateurs, comme carburant pour navires ou pour véhicules terrestres, et comme solution d'approvisionnement en gaz naturel pour des sites non-reliés au réseau. Son rôle dans l'approvisionnement énergétique mondial est en croissance. Le GNL ne doit pas être confondu avec le gaz de pétrole liquéfié, constitué principalement de propane et de butane, hydrocarbures saturés à 3 et 4 atomes de carbone respectivement (contre un seul pour le méthane) ; ni avec les liquides de gaz naturel, aussi appelés condensats, qui sont une essence naturelle obtenue par condensation des hydrocarbures allant du pentane (5 carbones) à l'octane (8 carbones) à la sortie des puits de gaz naturel. |

Histoire de l'automobile L’histoire de l’automobile rend compte de la naissance et de l’évolution de l’automobile, invention technologique majeure qui a considérablement modifié les sociétés de nombreux pays au cours du XXe siècle. Elle prend naissance au XIXe siècle lorsque la technique fait la part belle à la vapeur comme source d’énergie pour ensuite s’orienter massivement vers le pétrole et le moteur à explosion. L’automobile s’est progressivement imposée dans les pays développés comme le principal mode de transport pour la circulation des individus et des marchandises. Son industrie a été l’un des secteurs les plus importants et les plus influents depuis la fin de la Seconde Guerre mondiale et son essor mondial en a été spectaculaire. 250 000 automobiles sont dénombrées en 1907, 500 000 en 1914 avec l’apparition de la Ford T et 50 millions avant la Seconde Guerre mondiale. Le parc automobile triple pendant les Trente Glorieuses et atteint les 300 millions de véhicules en 1975. En 2007, la production annuelle mondiale de voitures passe le cap des 70 millions d’unités, et on estime que le parc pourrait dépasser le milliard en 2010… |

Moteur Wankel Le moteur Wankel (/[vɑ̃kɛl]/) est un moteur à piston rotatif décrivant un cycle quatre temps, dans lequel un piston « triangulaire » convertit l'énergie issue de la combustion du carburant en une énergie mécanique de rotation transmise au vilebrequin. Le moteur Wankel est, à tort, couramment désigné par le terme « moteur rotatif », bien que les fonctionnements des deux types de moteurs soient radicalement différents. Le principe du moteur Wankel est basé sur celui de la pompe à palettes, qui remonte à la deuxième moitié du XVIe siècle. Mais c'est seulement dans les années 1950 que le moteur est développé sous sa forme actuelle par celui qui lui a laissé son nom, l'ingénieur allemand Felix Wankel. NSU sera le premier constructeur à en obtenir la licence, équipant ses motos du moteur, avant de la céder à d'autres constructeurs. Contrairement au moteur à soupapes, le moteur Wankel n'utilise pas le principe du système bielle-manivelle. Il n'engendre aucun mouvement alternatif, ce qui réduit les transformations de mouvement, les frottements, les vibrations et le bruit. L'ensemble comporte également un nombre de pièces réduit. Ces avantages en font une solution technique séduisante ; il trouve une large gamme d'applications, dans tous les domaines des transports (automobiles, motos, aéronefs). Son utilisation dans des véhicules de série reste néanmoins minoritaire, principalement en raison de sa consommation importante et de problèmes d'étanchéité inhérents à son principe même. En 2009, dans le secteur automobile, seul le constructeur Mazda intègre encore ce moteur à ses véhicules. |

Ferrari 250 GT California Spyder La Ferrari 250 GT California Spyder est une sportive de prestige développée par le constructeur automobile italien Ferrari. Elle est présentée par la marque comme Ferrari 250 Granturismo Spyder California, ou simplement Ferrari 250 California, et son nom est parfois improprement écrit Spider. Dessinée par Pinin Farina et carrossée par la Carrozzeria Scaglietti, elle est « assurément l'une des plus belles Ferrari et l'un des plus beaux cabriolets de l'histoire de l'automobile ». Vedette du film La Folle Journée de Ferris Bueller, de 1986, elle deviendra l'une des Ferrari les plus appréciées. La 250 GT California Spyder n'est pas à proprement parler une spider, mais une déclinaison cabriolet de la berlinette contemporaine. Propulsée par le traditionnel moteur V12 Ferrari, elle sera produite à une centaine d'exemplaires, répartis à peu près équitablement entre une version châssis long (LWB pour long wheel base, de 1958 à 1960) et une version châssis court (SWB pour short wheel base, de 1960 à 1962). Le , une Ferrari 250 GT California Spyder SWB bleu nuit s'est vendue, lors des enchères « Ferrari Leggenda e Passione », organisées par Sotheby's, à un prix « record » de sept millions d'euros, devenant ainsi l'une des automobiles les plus chères de l'Histoire. |

Ferrari 250 GT Lusso La Ferrari 250 GT Lusso, parfois dénommée GTL ou GT/L — à ne pas confondre avec la Berlinetta Lusso, version spéciale de la 250 GT Berlinetta SWB — est une automobile de tourisme produite par le constructeur italien Ferrari. Déclinaison plus spacieuse et surtout plus luxueuse de la berlinette 250 GT, la 250 GT Lusso, qui n'est pas destinée à la compétition en Grand Tourisme, est considérée comme l'un des plus élégants modèles de Ferrari. Fidèle à la « tradition » Ferrari de l'époque, la 250 GT Lusso est dessinée par le carrossier turinois Pininfarina et carrossée par Scaglietti. Bien que l'habitacle soit plus spacieux que celui de la 250 GT, la GT Lusso demeure un coupé GT deux places, contrairement à la 250 GTE, coupé 2+2. Fabriquée pendant seulement dix-huit mois, de début 1963 à milieu 1964, elle est le dernier modèle de la génération des Ferrari 250 GT. |

Pont Un pont est une construction qui permet de franchir une dépression ou un obstacle (cours d'eau, voie de communication, vallée, etc.) en passant par-dessus cette séparation. Le franchissement supporte le passage d'hommes et de véhicules dans le cas d'un pont routier ou d'eau dans le cas d'un aqueduc. Les ponts font partie de la famille des ouvrages d'art et leur construction relève du domaine du génie civil. L’évolution de la technologie des ponts peut être divisée en deux périodes : la période romaine et la période contemporaine. L'Empire romain, qui occupait la majeure partie de l'Europe, maîtrisait les techniques de construction. Le pont représentatif de cette période était le pont en arc en plein cintre. Le matériau de construction de base était la pierre. Pendant plus de 2 000 ans, la conception des ponts n’a pas connu d’évolution. La période contemporaine a commencé avec la révolution industrielle, lorsque le développement des échanges commerciaux a nécessité la construction d'une grande quantité de réseaux de chemins de fer, de routes et de ponts et où parallèlement les connaissances théoriques ont fait des progrès considérables. Cette période a commencé il y a près de 200 ans. Elle est marquée par le développement des ponts en béton armé puis en précontraints, des ponts suspendus de grandes portées et des ponts à haubans, qui ont tous été rendus possibles avec l'introduction de l'acier. La forme des ponts évolue en fonction du matériau disponible. Jusqu’au XXIe siècle, deux matériaux ont principalement influencé la forme : la pierre et l’acier. De nouveaux matériaux issus de l’industrie de la construction ont été introduits et les méthodes et moyens de calculs ont évolué. Des prototypes de ponts ont été construits avec un béton à ultra hautes performances possédant une résistance à la compression pouvant aller jusqu’à 200 MPa. Des ponts ont également été construits avec des matériaux composites, assemblages de résines et de fibres de carbone, pouvant résister à des efforts extrêmement élevés. Des formes nouvelles sont apparues. L’histoire des ponts est en continuelle évolution. Cinq classes de ponts sont définies selon leur structure : les ponts voûtés, les ponts à poutres, les pont en arc, les ponts suspendus et les ponts haubanés. Des critères spécifiques conduisent pour chacune de ces classes à définir une typologie qui lui est propre. Le matériau utilisé est un des critères de différenciation communs à l’ensemble des classes. Selon le matériau, les modes de conception, de construction et de surveillance et d’entretien seront différents. Chaque type de pont est adapté à une plage de portée, les ponts suspendus permettant les plus grandes portées... |

Viaduc de Millau Le viaduc de Millau est un pont à haubans autoroutier franchissant la vallée du Tarn, dans le département de l'Aveyron, en France. Il franchit une brèche de 2 460 mètres de longueur et de 270 mètres de profondeur au point le plus haut, dans un panorama de grande qualité et avec des vents susceptibles de souffler à plus de 200 km/h. Dernier maillon de l’autoroute A75 permettant de relier Clermont-Ferrand à Béziers, ce projet a nécessité treize ans d'études techniques et financières. Les études ont commencé en 1988 et l’ouvrage a été inauguré le , seulement trois ans après la pose de la première pierre. Conçu par Michel Virlogeux et ses équipes pour ce qui concerne le tracé et les principes de franchissement, l’ouvrage a été dessiné par l’architecte Norman Foster. D’un coût de 320 millions d’euros, il a été financé et réalisé par le groupe Eiffage dans le cadre d’une concession, la première de ce type puisque sa durée est de 75 ans... |

Ferrari 250 GTE La Ferrari 250 GTE (Gran Turismo Evoluzione) ou GT 2+2, apparue en 1960, est une automobile de tourisme développée par le constructeur italien Ferrari, dessinée par Pininfarina et carrossée par Scaglietti. Même si quelques rares Ferrari – surtout des commandes spéciales – furent dotées d'un espace restreint derrière leurs deux seuls sièges, la 250 GTE inaugure une nouvelle gamme de carrosserie pour Ferrari, les « GT 2+2 ». En dépit d'une certaine condescendance des « puristes » automobiles, les GT 2+2 ou coupés 4 places connaissent un grand succès et deviennent, durant de nombreuses années, la spécialité du constructeur. D'ailleurs, la 250 GTE et sa descendante, la 330 GT, représentent à l'époque plus de 50 % de la production de la firme. Décrite comme « une voiture de tourisme non seulement grande, mais aussi glorieuse », la 250 GTE sera la Ferrari la plus vendue de son temps. En 1964, la 250 GTE est remplacée par la Ferrari 330 America, qui fut produite à 50 exemplaires pour la plupart exportés outre-Atlantique. Il s'agit stricto sensu du même modèle dont la cylindrée est augmentée à 4 litres. |

Aérodynamique automobile L’aérodynamique automobile est l’étude des phénomènes aérodynamiques induits par l’écoulement de l’air autour d’un véhicule automobile en mouvement. La connaissance de ces phénomènes permet entre autres, de réduire la consommation des véhicules en diminuant leur traînée, d’améliorer leur comportement routier en influant sur leur portance (ou leur déportance) et de diminuer les phénomènes aéroacoustiques ainsi que les turbulences à haute vitesse. Prise en compte très tôt dans l’histoire de l’automobile, à l’image de la Jamais Contente profilée comme une torpille, l’aérodynamique automobile a pris de l’ampleur dans les années 1930. C’est en effet en 1934 aux États-Unis que la Chrysler Airflow, première automobile de série dessinée en respectant un profil aérodynamique, voit le jour. Par la suite, les automobiles ne vont cesser de s’améliorer, notamment après l’apparition des Formules 1 dont le championnat suscite encore aujourd’hui beaucoup d’effervescence dans ce domaine… |

Science et ingénierie de Léonard de Vinci La science et l'ingénierie sont deux domaines, au-delà des arts plastiques, dans lesquels Léonard de Vinci s’est illustré à travers des recherches et dessins et dont témoignent ses carnets et projets de traités. Si sa motivation première est artistique — avec la représentation la plus juste possible des corps, de la nature, de l'ombre et de la lumière, ou encore des proportions —, il est entraîné dès les années 1480 dans des études aux directions variées, faisant de lui l'archétype des ingénieurs-artistes polymathes de la Renaissance : l'anatomie humaine et comparée ; les mathématiques et particulièrement la géométrie ; la botanique et la géologie ; l'optique et l'astronomie ; l'architecture, l'urbanisme et la cartographie ; les machines de guerre ou volantes ; en ingénierie, la mécanique générale ainsi que l'hydraulique. Participant à la Renaissance italienne, Léonard de Vinci se situe à ce moment charnière où les savants perçoivent, sans pour autant parvenir à les dépasser, les limites des théories scientifiques et l'inefficience des technologies contemporaines, héritées de l'Antiquité et encore ancrées dans le Moyen Âge. Se revendiquant scientifique et surtout ingénieur, il ne bénéficie cependant que d'une formation sommaire puisqu'il ne fréquente que deux ans une école pour futurs commerçants puis est intégré au sein de l'atelier d'Andrea del Verrocchio, lui-même artiste polymathe, qui lui fait découvrir la peinture et la sculpture, et l'initie également aux techniques permettant de les mettre en œuvre, comme la fonderie, la métallurgie ou l'ingénierie. En outre, l'importance et l'intensité de son travail dans chacun des domaines envisagés le conduisent presque invariablement à envisager la création d'un traité. Néanmoins, pas un seul n'est mené à son terme du fait de sa tendance à l'inachèvement. Diversement reconnu par ses contemporains, son parcours scientifique et d'ingénieur n'est que tardivement redécouvert au tournant des XVIIIe et XIXe siècles. D'abord considérée comme celle d'un génie absolu, inégalée et isolée parmi ses contemporains, la figure de Léonard est, au mitan du XXe siècle, fortement remise en question. Ses limites sont dès lors mises en avant, en particulier ses bagages : théoriques, du fait de ne pas avoir fréquenté les universités ; notionnels, par méconnaissance du grec et du latin alors porteurs du vocabulaire technique et scientifique. Pour autant, Léonard de Vinci est, à l'orée du XXIe siècle, replacé dans son contexte : il est désormais considéré comme un savant de son temps, héritier des connaissances et des croyances médiévales, et dont le travail bénéficie des avancées de contemporains comme celles de Filippo Brunelleschi, Giuliano da Sangallo ou Francesco di Giorgio Martini. Bien que ses apports soient relativisés, les historiens des sciences lui reconnaissent d'avoir introduit l'utilisation du dessin technique en tant que support de mémoire et pédagogique ; d'avoir poussé à leur perfection les techniques de représentations et de les avoir appliquées à tout sujet technologique. De même, son travail se distingue par son caractère systématique et par une attention aussi aiguë pour le détail que pour l'ensemble. Enfin, ses recherches se singularisent de ses contemporains par un souci de rentabilisation économique du travail par la recherche systématique de l'automatisation des mécanismes. |

Histoire du procédé Haber-Bosch L'histoire du procédé Haber-Bosch débute avec l'invention du procédé de chimie homonyme à l'aube du XXe siècle. Le procédé Haber-Bosch permet de fixer, de façon économique, le diazote atmosphérique sous forme d'ammoniac, lequel permet à son tour la synthèse de différents explosifs et engrais azotés. À ce double titre, du point de vue démographique, c'est probablement le plus important procédé industriel jamais mis au point durant le XXe siècle. Bien avant le début de la révolution industrielle, les agriculteurs qui « engraissent la terre » de différentes façons, savent les bénéfices d'un apport de nutriments essentiels à la croissance des plantes. Les travaux de Justus von Liebig permettent, dans les années 1840, d'identifier l'importance de l'apport en azote à cette fin. Par ailleurs, ce même composé chimique pouvait déjà être transformé en acide nitrique, précurseur de la poudre à canon et de puissants explosifs tel que le TNT et la nitroglycérine. Cependant, s'il est alors connu que l'azote constitue une part dominante de l'atmosphère terrestre, la chimie inorganique n'a pas encore établi de procédé pour le fixer. Ainsi, lorsqu'en 1909 le chimiste allemand Fritz Haber parvient à fixer l'azote atmosphérique en laboratoire, sa découverte présente à la fois un intérêt militaire, économique et agricole. Aussi n'est-il pas surprenant qu'en 1913, à peine cinq ans plus tard, une équipe de recherche de la société BASF dirigée par Carl Bosch mette au point la première application industrielle des travaux d'Haber : le procédé Haber-Bosch. Ce procédé servira de modèle, à la fois théorique et pratique, à tout un pan de la chimie industrielle moderne, la chimie à haute pression. La production industrielle d'ammoniac prolonge la Première Guerre mondiale en fournissant à l'Allemagne le précurseur de la poudre à canon et d'explosifs nécessaires à son effort de guerre, alors même qu'elle n'a plus accès aux ressources azotées traditionnelles, principalement exploitées en Amérique du Sud. Durant l'entre-deux-guerres, la synthèse, à moindre coût, d'ammoniac à partir du réservoir quasiment inépuisable que constitue l'azote atmosphérique contribue au développement de l'agriculture intensive et soutient la croissance démographique mondiale. Lors de la Seconde Guerre mondiale, les efforts d'industrialisation du procédé Haber profitent largement au procédé Bergius, lequel permet à la société IG Farben de réaliser la synthèse de carburant pour le compte de l'Allemagne nazie, réduisant d'autant ses importations pétrolières... |

Amplificateur électronique Un amplificateur électronique est un système électronique augmentant la tension et/ou l’intensité d’un signal électrique. L’énergie nécessaire à l’amplification est tirée de l’alimentation du système. Un amplificateur parfait ne déforme pas le signal d’entrée : sa sortie est une réplique exacte de l’entrée mais d’amplitude majorée. Les amplificateurs électroniques sont utilisés dans quasiment tous les circuits électroniques : ils permettent d’élever un signal électrique, comme la sortie d’un capteur, vers un niveau de tension exploitable par le reste du système. Ils permettent aussi d’augmenter la puissance maximale disponible que peut fournir un système afin d’alimenter une charge comme une antenne ou une enceinte. |

Appareillage électrique à haute tension L'appareillage électrique à haute tension est l'ensemble des appareils électriques qui permettent la mise sous ou hors tension de portions d'un réseau électrique à haute tension (y compris pour des opérations de délestage). L’appareillage électrique est un élément essentiel qui permet d’obtenir la protection et une exploitation sûre et sans interruption d’un réseau à haute tension. Ce type de matériel est très important dans la mesure où de multiples activités nécessitent de disposer d'une alimentation en électricité qui soit permanente et de qualité. L’appellation « haute tension » regroupe l'ancienne moyenne tension (HTA) et l'ancienne haute tension (HTB), elle concerne donc les appareils de tension assignée supérieure à 1 000 V, en courant alternatif, et supérieure à 1 500 V dans le cas de courant continu. Les applications industrielles des disjoncteurs à haute tension sont pour l'instant limitées au courant alternatif car elles sont plus économiques, il existe cependant des sectionneurs à haute tension pour liaisons à courant continu. |

Disjoncteur à haute tension Un disjoncteur à haute tension est destiné à établir, prendre en charge et interrompre des courants sous sa tension assignée (la tension maximale du réseau électrique qu’il protège) à la fois :

Un disjoncteur est un appareil de protection essentiel d’un réseau à haute tension, car il est le seul capable d’interrompre un courant de court-circuit et donc d’éviter que le matériel connecté sur le réseau soit endommagé par ce court-circuit. |

Thermoélectricité L'effet thermoélectrique, découvert puis compris au cours du XIXe siècle grâce aux travaux de Seebeck, Peltier ou encore Lord Kelvin, est un phénomène physique présent dans certains matériaux : il y lie le flux de chaleur qui les traverse au courant électrique qui les parcourt. Cet effet est à la base d'applications, dont très majoritairement la thermométrie, puis la réfrigération (ex. module Peltier) et enfin, très marginalement, la génération d'électricité (aussi appelée « thermopile »). Un matériau thermoélectrique transforme directement la chaleur en électricité, ou déplace des calories par l'application d'un courant électrique. Un grand nombre des matériaux possédant des propriétés thermoélectriques intéressantes ont été découverts au cours des décennies 1950 et 1960. C'est notamment le cas du tellurure de bismuth (Bi2Te3) utilisé dans les modules Peltier commerciaux, ou des alliages silicium-germanium (SiGe) utilisés pour l'alimentation des sondes spatiales dans des générateurs thermoélectriques à radioisotope. L'utilisation de la thermoélectricité en thermométrie connaît un grand succès depuis le début du XXe siècle et en réfrigération portable depuis les années 2000. Par contre, la thermopile a du mal à émerger car son rendement est peu élevé et les coûts sont importants, cela les limite à des utilisations très ciblées en 2005 (il n'y a pas encore de marché de niche pour la thermopile). Cependant des progrès récents, ainsi qu'un nouvel intérêt pour la thermoélectricité dû à la fois à la hausse des coûts de l'énergie et aux exigences environnementales, ont conduit à un renouveau important des recherches scientifiques dans cette discipline. |

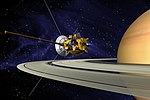

Cassini-Huygens Cassini-Huygens est une mission d'exploration spatiale de la planète Saturne et ses lunes par une sonde spatiale développée par l'agence spatiale américaine de la NASA avec des participations importantes de l'Agence spatiale européenne (ESA) et de l'Agence spatiale italienne (ASI). Lancé en octobre 1997 l'engin s'est placé en orbite autour de Saturne en 2004. En 2005 l'atterrisseur européen Huygens après s'être détaché de la sonde mère s'est posé à la surface de la lune Titan et a pu retransmettre des informations collectées durant la descente et après son atterrissage. L'orbiteur Cassini orbite depuis autour de Saturne et poursuit l'étude scientifique de la planète géante en profitant de ses passages à faible distance de ses satellites pour collecter des données détaillées sur ceux-ci. La mission d'une durée initiale de 4 ans a été prolongée à deux reprises : de 2008 à 2010 (Equinox mission) et de 2010 à 2017 (Solstice Mission). Il est prévu que la sonde spatiale s'écrase sur la planète Saturne à l'issue de cette dernière phase. Le principe d'une mission d'étude du système de Saturne émerge en 1982 à la fois dans les communautés scientifiques américaine et européenne. Après avoir travaillé sur des projets séparés, la NASA et l'Agence spatiale européenne lancent à la fin des années 1980 le développement d'une mission conjointe : la NASA développe l'orbiteur et l'ESA l'atterrisseur qui doit se poser sur Titan. Le projet frôle à plusieurs reprises l'annulation à la suite des difficultés budgétaires de la NASA. Des mouvements écologistes tentent d'interdire le lancement de la sonde spatiale à cause du plutonium embarqué pour alimenter en énergie la sonde spatiale. Finalement la sonde spatiale est lancée le 15 octobre 1997 par un lanceur lourd Titan IV-B. Cassini-Huygens est une mission particulièrement ambitieuse et couteuse (3,26 milliards $) rattachée à ce titre au programme Flagship de la NASA. Avec une masse totale de 5,6 tonnes (dont 3,1 tonnes de carburant et 350 kg pour l'atterrisseur Huygens) il s'agit du plus gros engin spatial lancé vers les planètes externes. L'orbiteur Cassini embarque 12 instruments scientifiques dont un radar tandis que Huygens en emporte six. Cassini est stabilisé trois axes et son énergie est fournie par trois générateurs thermoélectriques à radioisotope utilisant du plutonium. La mission Cassini-Huygens a rempli tous ses objectifs scientifiques en fournissant une moisson de données sur Saturne, sa magnétosphère, ses anneaux, Titan et les autres lunes de la planète géante. Les caméras de l'orbiteur ont également fourni certaines des plus belles images du système solaire. Cassini a notamment permis d'obtenir les premières images détaillées de Phœbé, d'analyser en détail la structure des anneaux de Saturne, d'étudier Titan de manière approfondie et de découvrir une dizaine de nouvelles lunes de Saturne de petite taille (moins de 10 km), portant le nombre total de satellites saturniens à 62 (nombre connu au 1er mai 2012). La sonde a permis également de découvrir de nouveaux anneaux de Saturne. |

Programme Apollo Le programme Apollo est le programme spatial de la NASA mené durant la période 1961 – 1975 qui a permis aux États-Unis d’envoyer pour la première fois des hommes sur la Lune. Il est lancé par John F. Kennedy le , essentiellement pour reconquérir le prestige américain mis à mal par les succès de l’astronautique soviétique, à une époque où la Guerre froide entre les deux superpuissances battait son plein. Le programme avait pour objectif de poser un homme sur la Lune avant la fin de la décennie. Le , cet objectif était atteint par deux des trois membres d’équipage de la mission Apollo 11, Neil Armstrong et Buzz Aldrin. Cinq autres missions se sont posées par la suite sur d’autres sites lunaires et y ont séjourné jusqu’à trois jours. Ces expéditions ont permis de rapporter 382 kilogrammes de roche lunaire et de mettre en place plusieurs batteries d’instruments scientifiques. Les astronautes ont effectué des observations in situ au cours d’excursions sur le sol lunaire d’une durée pouvant atteindre 8 heures, assistés à partir d’Apollo 15 par un véhicule tous-terrains, le rover lunaire. Aucun vol orbital n’avait encore été réalisé en mai 1961. Pour remplir l’objectif fixé par le président, la NASA lança plusieurs programmes destinés à préparer les futures expéditions lunaires : le programme Gemini pour mettre au point les techniques de vol spatial et des programmes de reconnaissance (Programme Surveyor, Ranger, etc.) pour, entre autres, cartographier les zones d’atterrissage et déterminer la consistance du sol lunaire. Pour atteindre la Lune, les responsables finirent par se rallier à la méthode audacieuse du rendez-vous orbital lunaire, qui nécessitait de disposer de deux vaisseaux spatiaux dont le module lunaire dédié à l’atterrissage sur la Lune. La fusée géante de 3 000 tonnes Saturn V, capable de placer en orbite basse 118 tonnes, fut développée pour lancer les véhicules de l’expédition lunaire. Le programme drainera un budget considérable (135 milliards de dollars US valeur 2005) et mobilisera jusqu’à 400 000 personnes. Deux accidents graves sont survenus au cours du projet : l’incendie au sol du vaisseau spatial Apollo 1 dont l’équipage périt brûlé et qui entraîna un report de près de deux ans du calendrier et l’explosion d’un réservoir à oxygène du vaisseau spatial Apollo 13 dont l’équipage survécut en utilisant le module lunaire comme vaisseau de secours. Les missions lunaires ont permis d’avoir une meilleure connaissance de notre satellite naturel. Le programme Apollo a favorisé la diffusion d’innovations dans le domaine des sciences des matériaux et a contribué à l’essor de l’informatique ainsi que des méthodes de gestion de projet et de test. Les photos de la Terre, monde multicolore isolé dans un espace hostile, ainsi que celles de la Lune, monde gris et mort, ont favorisé une prise de conscience mondiale sur le caractère exceptionnel et fragile de notre planète. Le programme est à l’origine d’une scission dans la communauté scientifique et parmi les décideurs entre partisans d’une exploration robotique jugée plus efficace et ceux pour qui l’exploration humaine à une forte valeur symbolique, qui justifie son surcoût. |

Boeing 757 Le Boeing 757 est un avion de ligne moyen-courrier biréacteur à fuselage étroit produit par Boeing Commercial Airplanes de 1981 à 2004. C'est le plus grand avion passagers monocouloir de cet avionneur. Prévu pour remplacer le triréacteur Boeing 727 sur des itinéraires courts et moyen-courriers, le 757 a une plus grande capacité (200 à 289 passagers) sur une distance maximale de 5 830 à 7 600 km, selon la version. Il est équipé de deux réacteurs à double flux, d'un empennage conventionnel et, pour réduire la traînée aérodynamique, d'un profil de voilure supercritique. Les deux membres d'équipage disposent d'une planche de bord tout écran. Les pilotes peuvent obtenir une qualification de type commune au 757 et au Boeing 767 à fuselage large, les deux appareils, conçus en même temps, ayant des caractéristiques communes. Le 757 est produit en deux longueurs de fuselage, les versions 200 et 300. Le 757-200 originel entre en service en 1983 suivi, vers la fin des années 1980, par le 757-200PF, version cargo, et le 757-200M, un modèle combi passagers-fret. Le 757-300 allongé, le plus long biréacteur à fuselage étroit jamais produit, est mis en service en 1999. Quelques 757-200 en version passagers seront modifiés au standard transport de fret exceptionnel ; les dérivés militaires comprennent une version transport, le C-32, une version VIP (transport de personnalités) et d'autres appareils polyvalents. Quelques 757 ont aussi été adaptés pour la recherche ou par des opérateurs privés ou gouvernementaux. Tous les 757 sont motorisés par les séries de turboréacteurs à double flux Rolls-Royce RB211 ou Pratt & Whitney PW2000. Le 757 entre en service commercial chez Eastern Air Lines et British Airways. Il succède aux avions de ligne monocouloirs de la génération précédente sur les itinéraires nationaux de courts et moyens courriers, les navettes et les vols transcontinentaux aux États-Unis. Il obtient la certification ETOPS en 1986 et peut alors être utilisé sur les routes transocéaniques. Les principaux clients du 757 sont les grandes compagnies aériennes américaines, les compagnies charter européennes et les compagnies cargo. Depuis sa mise en service et jusqu'en , l'avion a subi huit accidents avec perte de l'appareil, dont sept mortels. La production du 757 prend fin le avec un total de 1 050 appareils construits pour 54 clients, soit un bilan plus modeste que le 727. Le 757-200, construit en 913 exemplaires, est de loin le modèle le plus répandu. L'avion n'a pas de successeur direct en raison de la préférence des compagnies pour des avions monocouloirs plus petits issus la famille Boeing 737. Le dernier 757 est livré à Shanghai Airlines le . En , 689 appareils sont en service. |

Boeing 767 Le Boeing 767 est un avion de ligne à réaction gros-porteur de taille moyenne construit par Boeing Commercial Airplanes. Il est le premier biréacteur à fuselage large du constructeur et le premier avion de ligne à être équipé d'un cockpit à deux membres d'équipage avec une planche de bord tout écran. L'avion est équipé de deux turboréacteurs à double flux, d'un empennage conventionnel et, pour réduire la traînée aérodynamique, d'un profil de voilure supercritique. Conçu comme avion de ligne gros-porteur plus petit que les appareils précédents, tels que le 747, le 767 a une capacité allant de 181 à 375 personnes et une autonomie de 3 850 à 6 385 milles nautiques (7 130 à 11 825 km), selon les versions. Le développement du 767 ayant été fait en simultané avec celui d'un biréacteur à fuselage étroit, le 757, les deux appareils partagent des caractéristiques communes ; de ce fait, une certification unique permet de piloter les deux appareils. Le 767 est produit dans trois longueurs de fuselage différentes. Le 767-200 original entre en service en 1982, suivi par le 767-300 en 1986 et le 767-400ER, une version de portée accrue (extended-range, ER), en 2000. Les modèles 767-200ER et 767-300ER, à autonomie accrue, entrent respectivement en service en 1984 et 1988, tandis qu'une version cargo, le 767-300F, fait ses débuts en 1995. Des programmes de conversion ont modifié des 767-200 et 767-300 de passagers pour un usage cargo, tandis que les dérivés militaires comprennent l'avion de surveillance E-767, les ravitailleurs en vol KC-767 et KC-46, et des transports VIP. Les moteurs installés sur le 767 peuvent être les turboréacteurs à double flux General Electric CF6, Pratt & Whitney JT9D et PW4000, et Rolls-Royce RB211. United Airlines met le premier 767 en service en 1982. L'appareil est initialement exploité sur les lignes intérieures et transcontinentales, sur lesquelles il montre la fiabilité de sa conception biréacteur. En 1985, le 767 devient le premier avion de ligne bimoteur à recevoir l'approbation réglementaire pour des vols transocéaniques (ETOPS 120). L'avion est ensuite utilisé pour développer un service sans escale sur les itinéraires intercontinentaux moyen et long-courriers. En 1986, Boeing commence à étudier un 767 à plus grande capacité, qui conduit finalement au développement du 777, un plus gros biréacteur gros-porteur. Dans les années 1990, le 767 devient l'avion de ligne le plus fréquemment utilisé pour des vols transatlantiques entre l'Amérique du Nord et l'Europe. En juin 2016, le 767 avait reçu 1 170 commandes de 74 clients, dont 1 088 avaient été livrées ; 795 de ces appareils étaient en service en août 2014. La version la plus populaire est le 767-300ER, avec 583 livraisons, et Delta Air Lines est le principal opérateur, avec 95 appareils. Les principaux concurrents sont les Airbus A300, A310 et A330-200, tandis qu'un successeur, le 787 Dreamliner, entre en service en octobre 2011. |

Canal de Panama Le canal de Panama est un canal important traversant l’isthme de Panama en Amérique centrale, reliant l’océan Pacifique et l’océan Atlantique. Sa construction a été un des projets d’ingénierie les plus difficiles jamais entrepris. Son impact sur le commerce maritime a été considérable puisque les navires n’ont plus eu besoin de faire route par le cap Horn et le passage de Drake à la pointe australe de l’Amérique du Sud. Un navire allant de New York à San Francisco par le canal parcourt 9 500 kilomètres, moins de la moitié des 22 500 kilomètres d’un voyage par le cap Horn. Bien que le concept d’un canal à Panama remonte au début du XVIe siècle, la première tentative de construction commença en 1880 sous l’impulsion française. Après que cette tentative eut échoué, le travail fut terminé par les États-Unis d’Amérique et le canal ouvrit en 1914. La construction des 77 kilomètres du canal a été parsemée de problèmes, incluant des maladies comme le paludisme et la fièvre jaune et des glissements de terrain. On estime à 27 500 le nombre d’ouvriers qui périrent pendant la construction. Depuis son ouverture, le canal a remporté un énorme succès et continue d’être un point de passage stratégique pour la navigation. Chaque année le canal permet le passage de plus de 14 000 navires transportant plus de 203 millions de tonnes de cargaison. Jusqu'à 2002, un total de 800 000 navires étaient passés par le canal. Des travaux d'élargissement du canal ont été lancés en septembre 2007 et devraient être terminés en 2014, permettant alors à des navires encore plus gros d'emprunter le canal. En 2007, la canal a été consacré l'une des sept merveilles du monde moderne. |

Motoneige Une motoneige (également appelée scooter des neiges en France et, par antonomase, Ski-Doo au Québec, habituellement écrit skidoo (marque déposée par BRP) est un petit véhicule motorisé, mû à l'aide d'une ou deux chenilles, et équipé de skis pour la direction. Elle ne nécessite ni route, ni piste. Conçue pour un usage utilitaire ou de loisir, elle est alors utilisée pour la randonnée dans les régions urbanisées du sud des pays nordiques. Son développement au cours du XXe siècle a considérablement modifié les déplacements dans les régions arctiques en remplaçant les moyens de transport traditionnels tels que les traîneaux à chiens ou à rennes en augmentant grandement la mobilité des populations concernées. Un pilote de motoneige ou une personne pratiquant ce sport est un motoneigiste. |

Pont du Forth Situé à 14 kilomètres à l’ouest de la ville écossaise d’Édimbourg, le pont du Forth est le deuxième plus long pont de type cantilever au monde quant à sa portée libre (le premier étant le Pont de Québec) et le premier de grande taille jamais construit. Sa longueur est supérieure à 2,5 kilomètres. Il est uniquement destiné au trafic ferroviaire et permet de relier le council area d’Édimbourg à celui de Fife and Kinross en enjambant le fleuve Forth. Il constitue ainsi un axe majeur de transport entre le nord-est et le sud-est du pays, doublé depuis 1964 par le pont autoroutier du Forth. Il est inscrit depuis 1999 sur la liste indicative du patrimoine mondial de l’UNESCO. |

Pont George-V Le pont d'Orléans, dénommé pont Royal, puis pont National et, au cours de la Première Guerre mondiale, pont George-V en l'honneur du roi d'Angleterre George V, est un pont voûté en maçonnerie franchissant la Loire à Orléans, dans le département du Loiret, en France. Il est situé à 1,2 km en aval du pont René-Thinat et 700 mètres en amont du pont Maréchal-Joffre, dans l'axe de la rue Royale, sur la rive droite, et de l'avenue Dauphine, sur la rive gauche. Le XVIIIe siècle a été, en France, un âge d'or pour la construction des ponts, tant par le nombre de ceux qui furent édifiés que par les progrès réalisés dans l'exécution et la structure de ce type d'ouvrages. Le pont George-V figure parmi ces ouvrages remarquables. Il a été construit de 1751 à 1760 selon les plans de Jean Hupeau. C'est Daniel Trudaine, conseiller d'État, intendant des finances chargé du détail des Ponts-et-Chaussées de 1743 à sa mort en 1769, qui le fit exécuter. Les travaux furent dirigés par Hupeau, assisté de Robert Soyer et de deux stagiaires, Jean Cadet de Limay et François Lecreux. |

Base sous-marine de Lorient La base sous-marine de Lorient, ou encore base de sous-marins de Keroman, est un complexe de bunkers de la Seconde Guerre mondiale, situé à Lorient (Bretagne, France). Elle occupe l'extrémité de la presqu'île de Keroman, dans la rade de Lorient et donne sur le golfe de Gascogne. Elle prend le nom de base de sous-marins ingénieur général Stosskopf en 1946. Construite entre 1941 et 1944 par l'Allemagne nazie pendant l'Occupation, elle est alors destinée à abriter les 2e et 10e flottilles de U-boote de la Kriegsmarine, tout en s'inscrivant dans le dispositif du mur de l'Atlantique. Sa présence est la cause de la destruction de la ville de Lorient par les aviations anglaise et américaine en janvier et février 1943, puis de la reddition tardive de la poche de Lorient le . La base sous-marine est récupérée par la Marine nationale après le conflit et sera utilisée jusqu'en 1997 comme base de sous-marins. Géré par la Marine dans le cadre du développement du programme de SNLE français, et pour la création de constructions navales à base de matériaux composites, le site est consacré depuis lors à des activités civiles dont le pôle d'activité est centré sur le domaine maritime. Depuis la fin des années 1990, le site est reconverti en un pôle nautique spécialisé dans la plaisance et la course au large. Il accueille par ailleurs un centre d'affaires tourné vers le monde maritime, un musée aménagé dans le sous-marin Flore, ainsi que la Cité de la voile Éric Tabarly. Le complexe est composé de trois bunkers, Keroman I, II et III, de deux Dom-Bunkers situés dans l'espace du port de pêche de Keroman, ainsi que d'un bunker situé à Lanester sur les rives du Scorff. Le tout a nécessité le travail de 15 000 personnes et le coulage de près d'un million de mètres cubes de béton. Les trois bunkers de Keroman comptent entre cinq et sept alvéoles destinées à accueillir des U-boote, couverts par des toits d'une dizaine de mètres d'épaisseur. |

Classe 1 500 tonnes Les sous-marins de première classe dits 1 500 tonnes sont une classe de 31 sous-marins d'attaque à propulsion classique construits en France entre 1924 et 1937 pour la Marine nationale française et ayant servi durant la Seconde Guerre mondiale. Ils étaient classés « sous-marins de grande croisière » par la Marine nationale et parfois appelés la classe Redoutable, du nom du premier sous-marin de la série construit. Les 1 500 tonnes sont divisés en deux séries relativement homogènes, les types M5 (Redoutable) et les types M6 (Pascal). Sous-marins modernes lors de leur conception, ils deviennent vite obsolètes lors de la Seconde Guerre mondiale et 24 des 29 unités engagées sont perdues pendant le conflit. Après avoir protégé l'empire colonial français au service du Régime de Vichy contre les offensives britanniques à Dakar, Libreville ou Madagascar au prix de lourdes pertes, les 1 500 tonnes rejoignent le camp allié après le débarquement en Afrique du Nord. Hormis le Casabianca, qui s'est rendu notoire lors de la libération de la Corse, ces sous-marins participent peu au reste du conflit, notamment en raison des importantes refontes effectuées aux États-Unis entre et . Devenus unités d'entraînement, les derniers sous-marins de 1 500 tonnes sont désarmés en 1952. |